ResNet [He et al,. 2015]

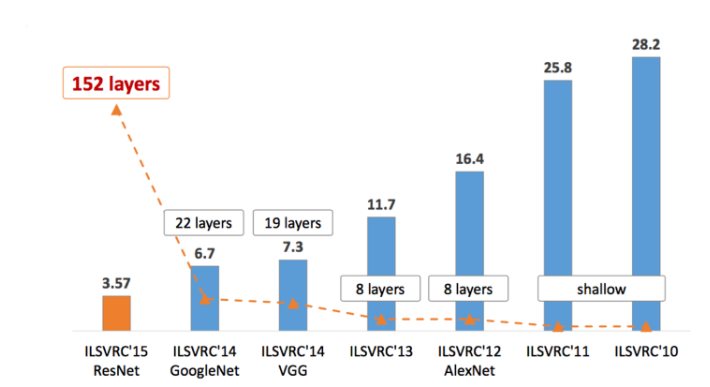

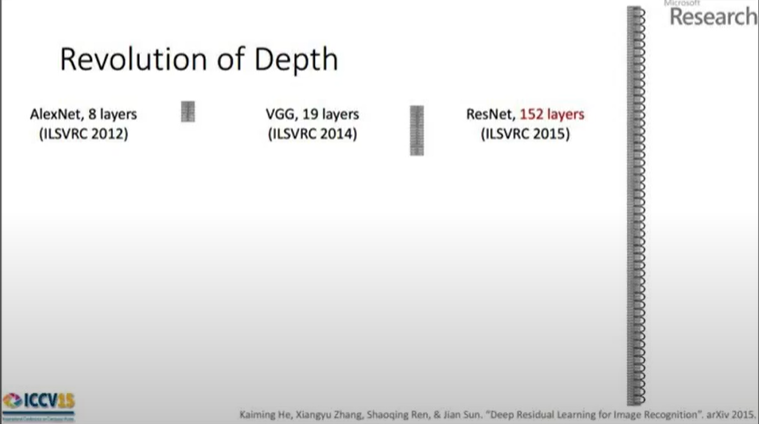

googlenet과 vggnet이 나온 바로 다음해 imagenetchalenge에서 152 layer을 사용해 우승한 resnet

degradation problem : network가 깊어질수록 accuracy가 떨어지는(성능이 저하)문제.

vanishing gradient : 깊이가 깊어짐에 따라 많은 가중치값들이 소실되어 (작은 미분값이 0에 가까워짐)feature map이 점점 의미를 잃어가는 현상

exploding gradient : learning rate가 커짐에 따라 가중치값이 수렴하지 않고 발산하는 형태

overfitting : train data가 model에 과도하게 적합하게 학습된 상태 >> data로 인해 발생

degradation : 학습 과정에서 network가 깊어질 때 발생

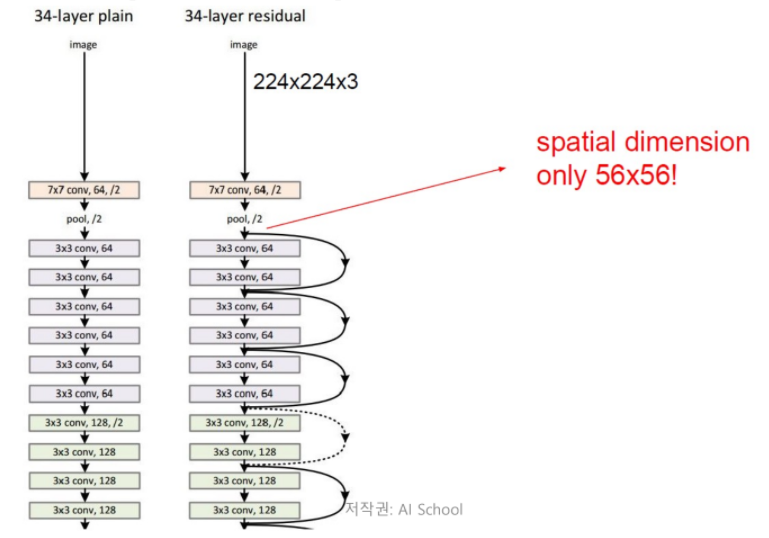

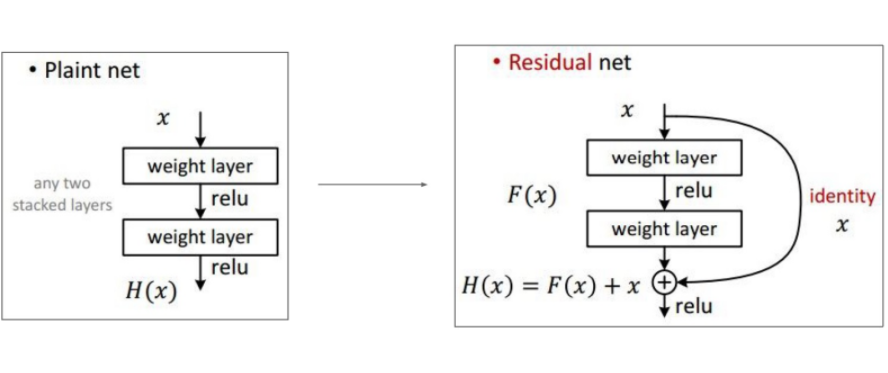

Res : Residual(남은, 잔여의, 수학적으로 예측값과 실제값의 차이) >> residual connection / skip connection

residual을 copy해 connection시킴

residual connection을 이용해 이전의 impact있는 weight 정보를 이후의 layer까지 계속해서 넣어줄 수 있다.

backpropagate의 통로가 1개가 추가되므로 정보를 손실 없이 전달

deep residual learning framework(잔여학습)

input값 x가 model인 F(x)의 과정을 거치고, 자기자신인 x가 더해져 output으로 F(x) + x가 나오는 구조

Plain net의 출력 : H(x) (original mapping) >> variance가 크다.

Residual net의 출력 : H(x) (residual mapping)= F(x) + x (재구성)