EfficientNet [ Mingxing Tan, Quoc V. Le]

Rethinking Model Scaling for Convolutional Neural Networks

conv 네트워크 모델의 크기를 키우는 방법 (accuracy & efficiency의 측면)

1. layer depth를 키우기

2. channel width를 늘리기

EfficientNet은 한정된 자원으로 이 3가지의 최적의 조합(constant ratio)을 compound scailing 방법을 통해 연구한 논문이다.

기존에 나온 모델들을 조금 더 효율적으로 하기 위한 고찰로부터 비롯

mobileNet

G pipe - 2018년 557M parameter로 84.3%의 accuracy를 달성 >> hardware memory limit에 부딪히게 되어 효율적인 모델을 고려하게 됨.

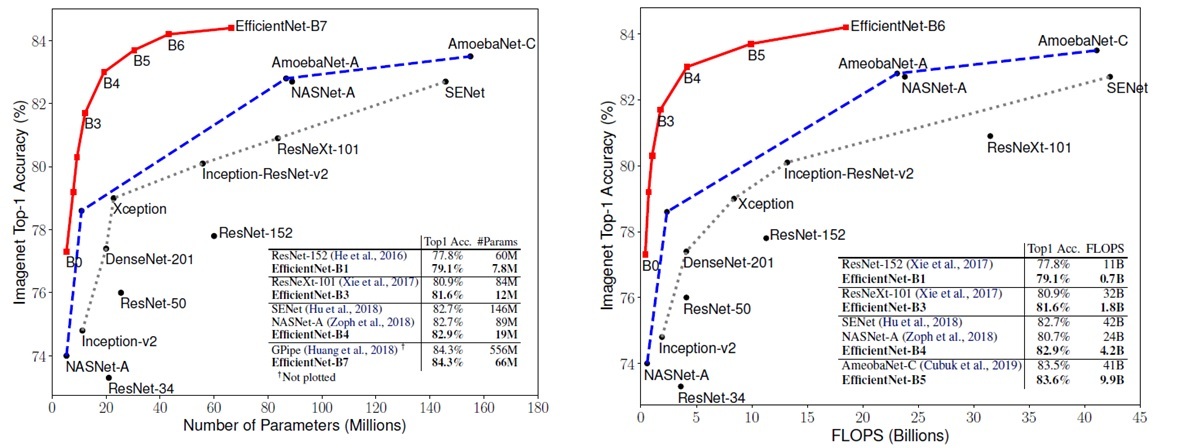

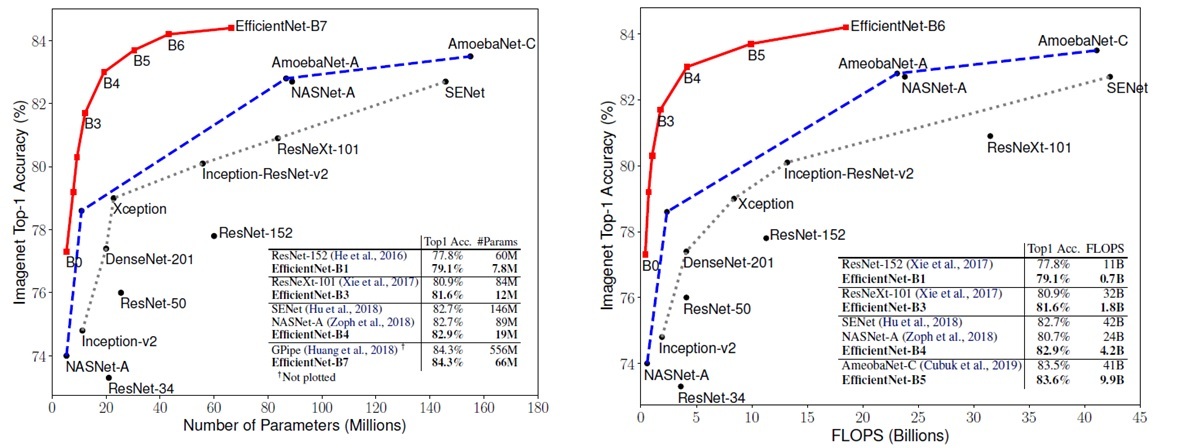

기존의 다른 네트워크와 EfficientNet의 성능 비교

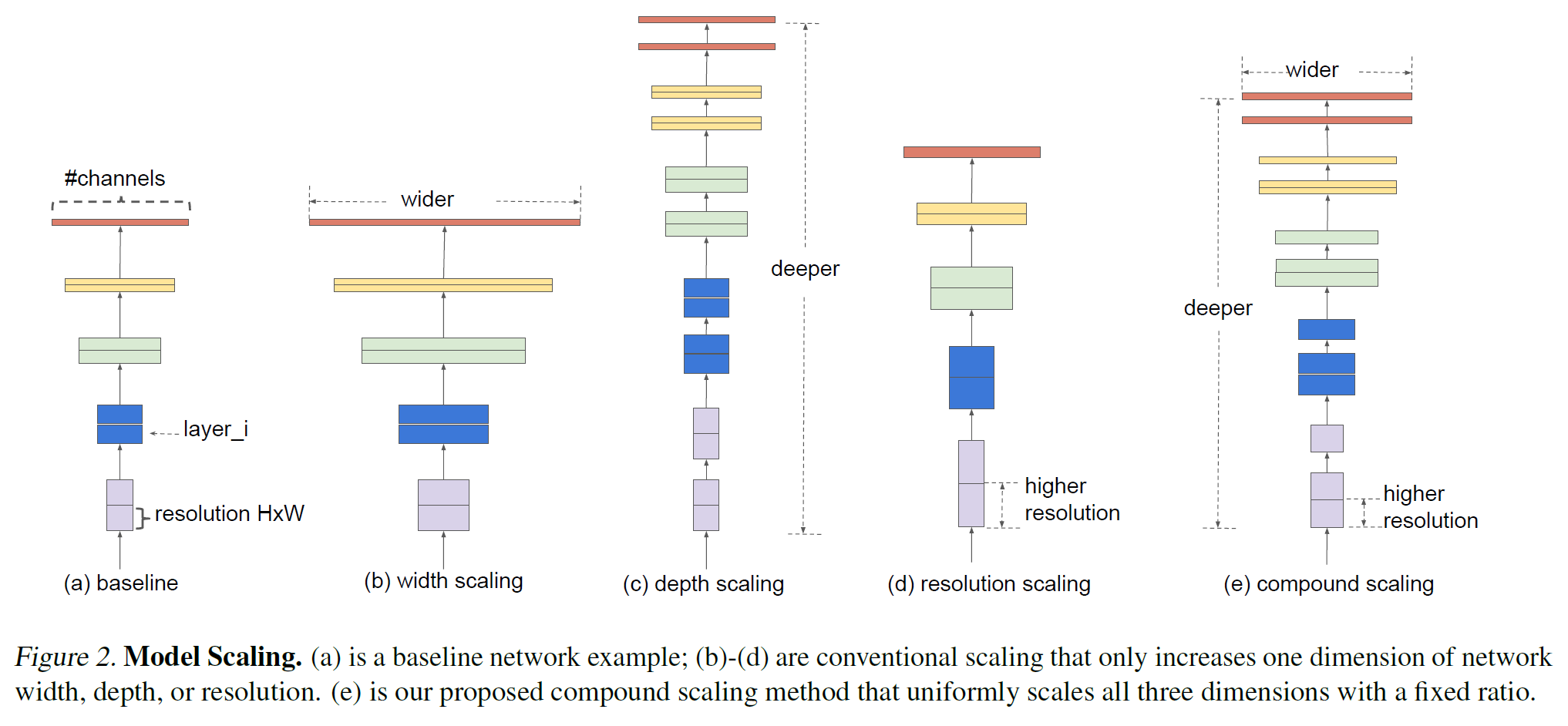

Model Scailing

width, depth, resolution을 모두 고려한 compound scailing

기존 baseline모델에서 width, depth, resolution 관점에서 scailing을 적절한 비율로 조합해 compound scailing model을 만들어 내었다.

Depth(d) : 가장 흔한 scale-up 방법으로, 깊은 layer은 더 높은 성능을 낸다.

하지만 layer를 계속 깊게 쌓다보면 Gradient Vanishing problem현상으로 학습이 어렵다.

Width(w) : 대개 작은 크기의 모델들이 사용하는 방법