https://proceedings.neurips.cc/paper/2012/file/c399862d3b9d6b76c8436e924a68c45b-Paper.pdf

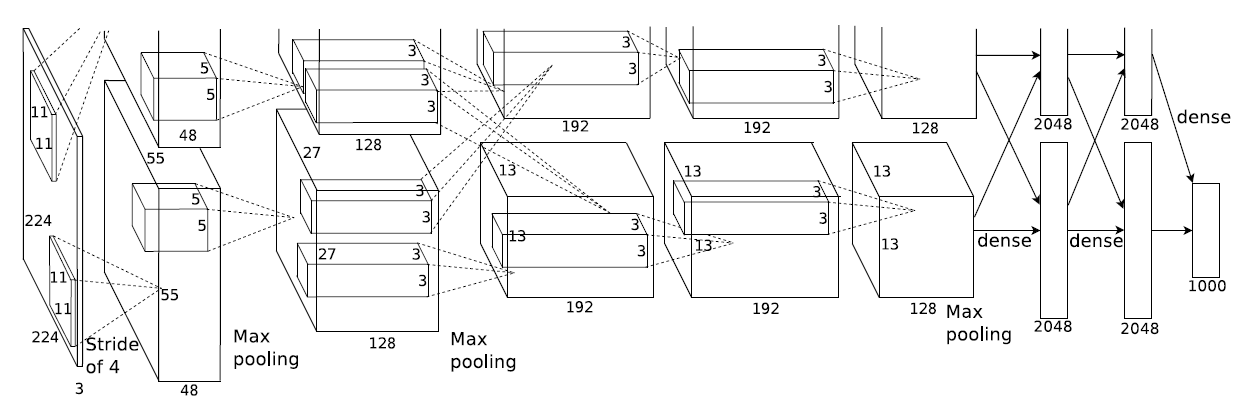

AlexNet[Krizhevskv et al., 2012]

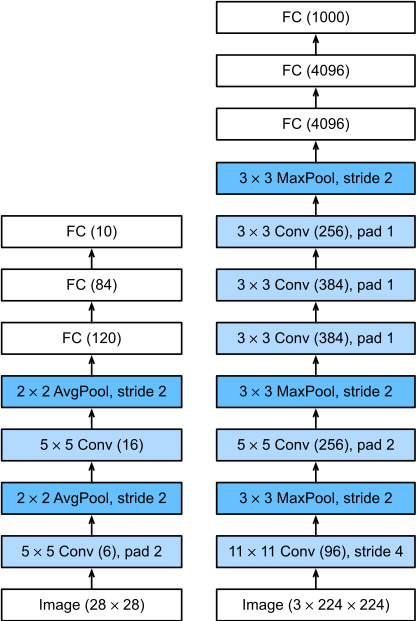

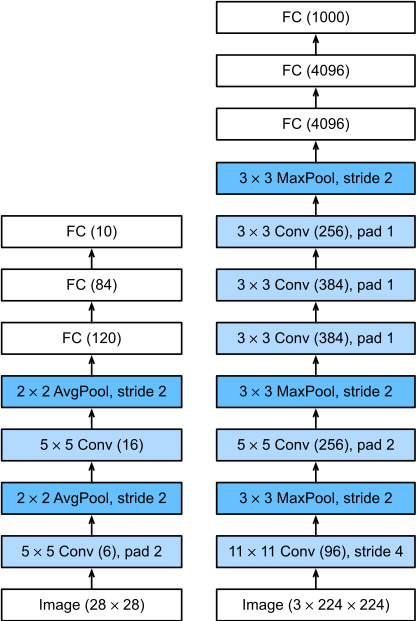

LeNet(좌), AlexNet(우)

목표

더 깊은 네트워크를 만들면서 성능을 높여간다.

5개의 Convolution층과 3개의 Fully-connected layer가 연결된 아키텍처로 구성

Fully- connected layer의 마지막 부분은 softmax 함수를 사용해 1000개의 output을 출력

3. Architecture

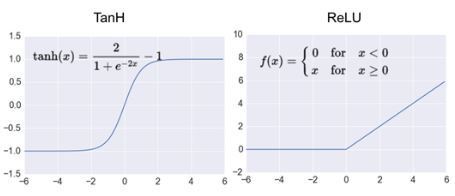

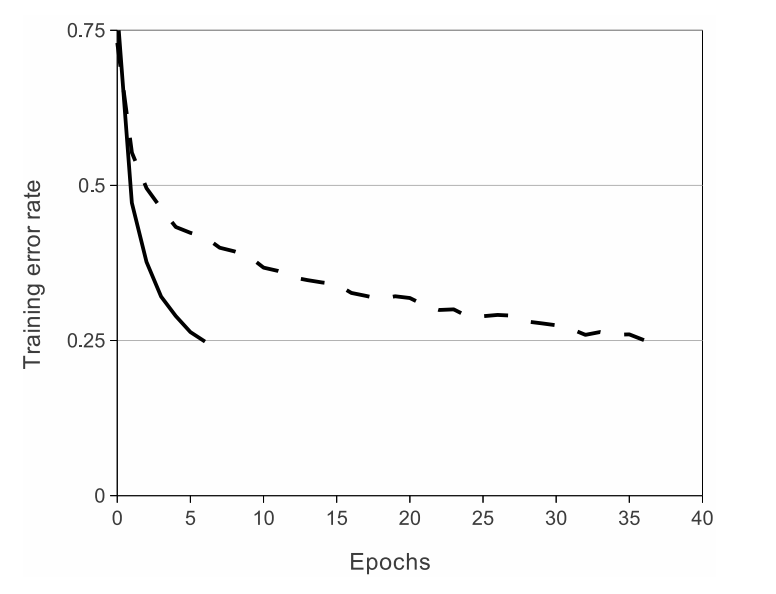

3.1 ReLU Nonlinearity

활성화 함수로 ReLU함수를 적용

이전까지 사용한 tanh함수는[-1,1] 범위에서 존재하는 saturating function이다.

반면 ReLU함수는 [0, ∞]의 범위에 존재한다. 따라서 non-saturating한 함수이다.

점선 tanh 실선 ReLU