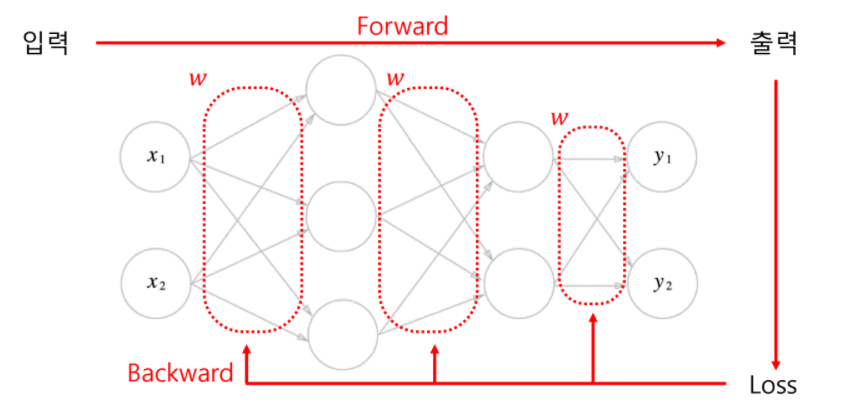

Back propagation

Loss를 바탕으로 각각의 w 하나하나가 얼마나 영향을 주었는지 알아내고, 좀 더 적절한 방향으로 w들을 변경해 나가는 것

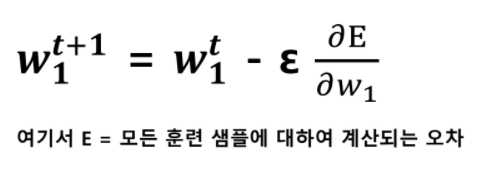

Gradiend decent(경사 하강법) = Back propagation의 수단

임의의 한 지점으로부터 시작해 loss가 줄어드는 방향으로 w(weights = parameters)들을 갱신하는 방법

loss가 더이상 감소하지 않는 시점까지 w를 음의 기울기 방향(-)으로 조금씩 움직이는 것을 여러 번 반복

목적지 : loss의 최소 지점

목적지의 방향 : 미분을 이용

목적지의 방향으로 얼마만큼 이동해야 하는가? : Learning rate

learning rate가 작으면 : 최저점을 찾는 과정이 매우 더딤

learning rate가 크면 : 최저점을 찾지 못할 수 있음

따라서 적절한 learning rate가 이상적이다!

Forward 과정을 통해 나온 Loss에 각 w들이 끼친 영향을 알기 위해서는 전체 loss를 각각의 w로 편미분 해야한다.

하지만 loss를 직접적으로 w에 대해 미분하기란 쉽지 않다.