학습의 과정

2.Loss and Gradient = Backward propagation = 역전파

Loss function

회귀(Regression)문제 >> Mean Squared Error(평균 제곱 오차)

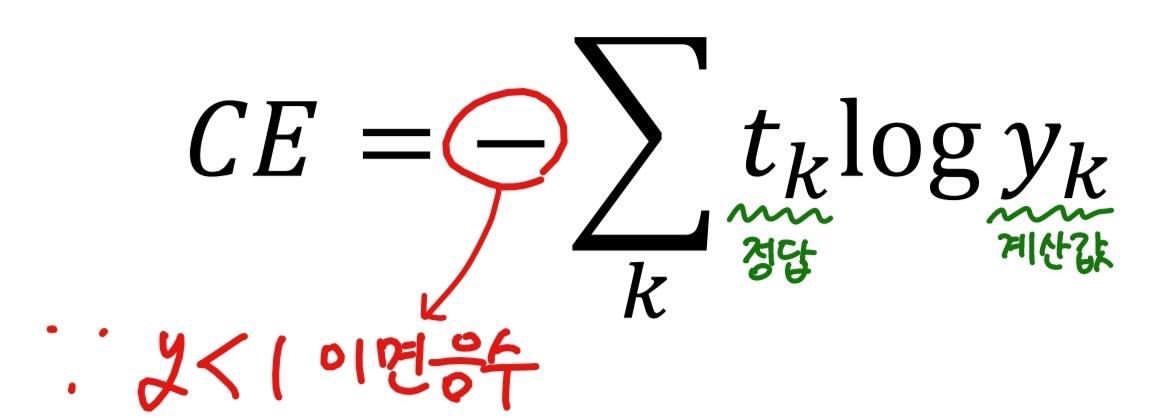

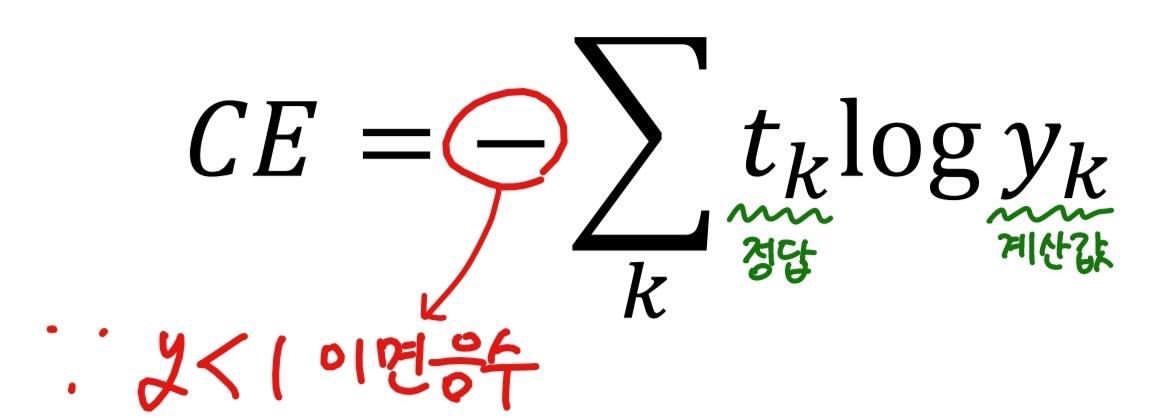

분류(Classification)문제 >> Cross Entropy(교차 엔트로피 오차)

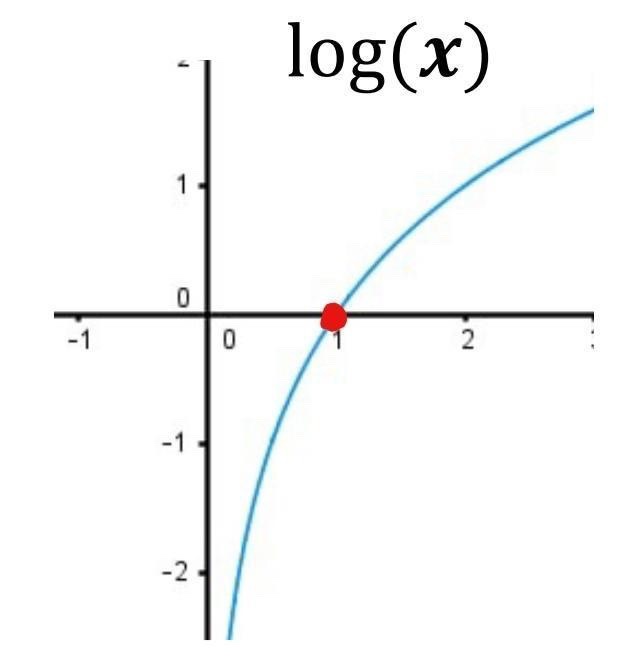

-정답일 때의 출력이 전체 값을 결정

-실제 정답이 아닌 요소에 대해 잘못 예측한 값은 Loss에 포함돼지 않아 계산의 효율성이 올라간다.

-cross entropy : 서로 다른 두 상태의 정보량 차이를 나타내는 척도

정보이론 관점에서 얼만큼의 정보를 갖고 있는지 정량적으로 표현하기 위해 사용하는 척도

너무 뻔해서 결과가 예측돼는 상황 > 엔트로피가 작다

결과를 예측할 수 없는 상황 > 엔트로피가 크다

Back propagaton